“AI 워크로드를 위해 설계된 차세대 맞춤형 칩(custom-made chips)은 이전 세대에 비해 성능이 크게 향상되었으며, 페이스북 및 인스타그램에서 순위 및 추천 광고 모델을 강화하는 데 도움이 된다. 이 칩은 AI 인프라에 대한 투자 증가의 일부이며, 앱과 기술 전반에 걸쳐 새롭고 더 나은 경험을 제공할 것이다.”

메타가 2023년 발표한 1세대 맞춤형 AI 가속기인 ‘1세대 MTIA(First Gen MTIA)’의 성능을 개선한 ‘차세대 MTIA(Next Gen MTIA)'를 공개했다. MTIA(Meta Training and Inference Accelerator)는 AI 학습과 추론을 위한 전용 가속기로 메타가 직접 개발한 맞춤형 AI 칩셋이다.

메타는 생성형 AI 제품 및 서비스, 추천 시스템, 고급 AI 연구 지원 등을 염두에 두고 자체적으로 맞춤형 AI 칩을 개발하고 있으며, 이번에 공개한 차세대 MTIA는 기존 1세대와 비교할 때 다양한 부분에서 성능을 개선했다. 자사의 서비스에 최적화된 AI 워크로드에서 효율적인 아키텍처를 제공해 경쟁력을 높이겠다는 전략이다.

메타는 “이 칩의 아키텍처는 기본적으로 순위 및 추천 모델을 제공하기 위해 컴퓨팅, 메모리 대역폭 및 메모리 용량의 적절한 균형을 제공하는 데 중점을 두고 있다. 추론에서는 배치 크기(batch sizes)가 상대적으로 작은 경우에도 상대적으로 높은 활용도를 제공할 수 있어야 한다”고 개발 배경을 밝혔다.

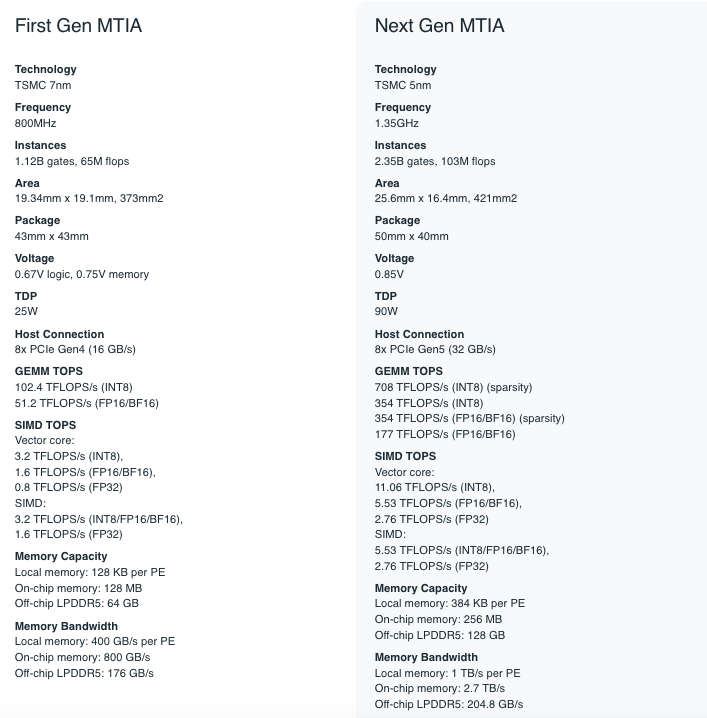

이를 위해 “일반적인 GPU에 비해 더 큰 SRAM 용량을 제공하는 데 중점을 둠으로써, 배치 크기가 제한된 경우 높은 활용도를 제공하고 더 많은 양의 잠재적 동시 작업을 경험할 때 충분한 컴퓨팅을 제공할 수 있다. 로컬 PE(processing elements) 스토리지 크기는 3배, 온칩 SRAM은 2배, 대역폭은 3.5배, LPDDR5의 용량은 2배로 늘어났다”고 밝혔다.

차세대 MTIA는 TSMC의 5nm(나노미터) 기술을 적용해, 7nm 기술을 사용했던 1세대 보다 한 단계 진화했다. 동작 속도는 1.35GHz로 1세대의 800MHz 보다 빨라졌고, 대역폭을 늘리면서 짧은 지연 시간으로 여러 PE 간에 조율할 수 있는 향상된 네트워크 온 칩(NoC) 아키텍처를 특징으로 한다.

차세대 MTIA의 TDP는 90W(1세대 25W), 호스트 연결은 8x PCIe Gen5 (32 GB/s)로 업그레이드했다. 또한, 3개의 섀시로 구성된 대규모 랙 시스템을 개발해, 하나의 랙체 최대 72개의 가속기를 탑재해 성능과 효율을 높일 수 있도록 했다.

메타는 “초기 결과에 따르면 차세대 MTIA은 우리가 평가한 4개의 주요 모델에서 이미 1세대 칩에 비해 3배의 성능 향상을 보였다. 플랫폼 수준에서는 2배의 디바이스 수와 강력한 2소켓 CPU를 통해 1세대 MTIA 시스템 대비 6배의 모델 처리량과 1.5배의 와트당 성능 향상을 달성했다”고 밝혔다.

⧉ Syndicated to WWW.CIOKOREA.COM

'🅣•TREND•TECHNOLOGY > ARTIFICIAL INTELLIGENCE' 카테고리의 다른 글

| “AI 신뢰성, 정확・완전・안전한 데이터가 좌우”…세일즈포스, 신뢰는 기업 AI의 핵심 (0) | 2024.04.24 |

|---|---|

| 웨어러블 AI 2029년까지 17.2% 성장…스마트워치 & 온디바이스가 성장 견인 (0) | 2024.04.12 |

| 최대 3분 길이 스테레오 음악 생성…스태빌리티.에이아이, ‘스테이블 오디오 2.0’ 발표 (0) | 2024.04.08 |

| “CMO, 생성형 AI 운영에 신뢰 얻어야”…가트너, AI 도입에 따른 브랜드 신뢰 방안 조언 (0) | 2024.04.05 |

| 고객 경험 향상, 멀티모달 AI로 CX 혁신…구글, AI 적용 컨텍센터로 진화 (0) | 2024.04.04 |

| AI가 유용하다고 느끼는 데 ‘하루 11분 씩 11주’…MS, 코파일럿 사용자 설문 (0) | 2024.03.22 |

| 빅테크 기업 AI 스타트업에 집중 투자…규제로 인한 인수 위축이 투자 늘려 (0) | 2024.03.19 |

| 감사 업무에도 생성형 AI 활용 증가…가트너, 41%가 사용 중이거나 계획 (0) | 2024.03.13 |